„Изгледах стотици ужасяващи видеоклипове“

- Здравни

- Текст:

Снимка: mind-berry.com

Снимка: mind-berry.com

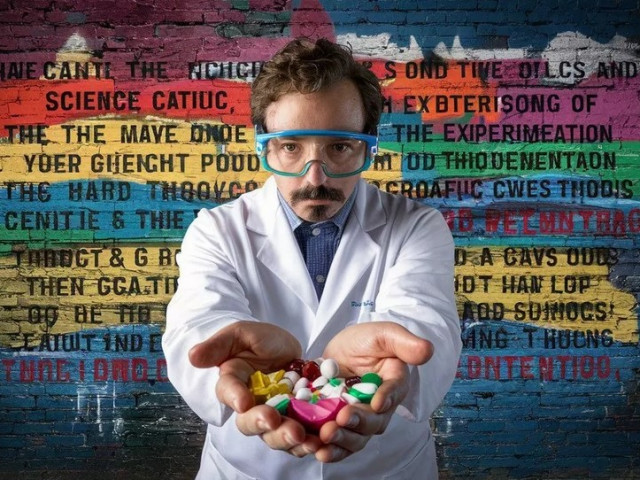

Обезглавявания, масови убийства, малтретиране на деца, реч на омразата – всичко това минава през входящата им поща. Работата им е да преглеждат и да изтриват съдържание, което или е докладвано от други потребители, или автоматично е маркирано от технически инструменти като вид насилие.

Проблемът с онлайн безопасността става все по-важен, но и по-голям. Технологичните компании са подложени на натиск да премахват бързо вредни материали. Въпреки многото изследвания и инвестиции в технически решения, в крайна сметка последна дума имат хората, нагърбили се с тази задача - огромната армия модератори в цял свят.

Разследване на ВВС разкри, че голяма част от тези служители в Източна Африка са напуснали работата си, въпреки тежката безработица в региона, заради „твърде бруталните случаи”, на които са станали свидетели онлайн. Според бивш модератор от Найроби, Кения, който е работил върху съдържанието на TikTok, личното му психично здраве е „поело удара”, предпазвайки милионите потребители.

Технологичните компании са затрупани с правни искове на модератори, които казват, че работата е съсипала психиката им. През 2020 г. Meta, тогава Facebook, плати обезщетение от $ 52 милиона на модератори, развили психични проблеми. Една от подалите иск от САЩ описва позицията „модератор” като „пазител на душите“ заради огромното количеството кадри, запечатали „последните моменти от живота на хората”.

Пред ВВС бивш модератор се оплаква, че му се причува бебешки плач и има чести пристъпи на паника. Друг казва, че трудно общува със съпругата и децата си, след като е гледал стотици клипове с насилие над деца.

И въпреки разклатената им психика, повечето бивши модератори се приемат като жизненоважна спешна служба и се гордеят с работата си, защитавайки милиони хора от травми – като парамедиците или пожарникарите. Нещо повече – те с готовност предават опита си в обучението на инструменти с изкуствен интелект (ИИ), надявайки се технологията скоро да поеме основната част от защитните им функции.

Бивш ръководител на отдела за доверие и безопасност в OpenAI, компанията създател на ChatGPT, казва, че благодарение на модератори с опит и на основата на чатбота, екипът му е създал елементарен инструмент за модериране, който идентифицира вредно съдържание с точност от около 90%.

Не всички обаче са уверени, че ИИ е „сребърният куршум” за проблемния сектор на модерирането. Експертите се опасяват от по-груб и елементарен начин на модериране и дори проблеми със свободата на словото. Освен това, от изкуствения интелект не може да се очаква да улови всички нюанси, които хората биха приели като психическо насилие.

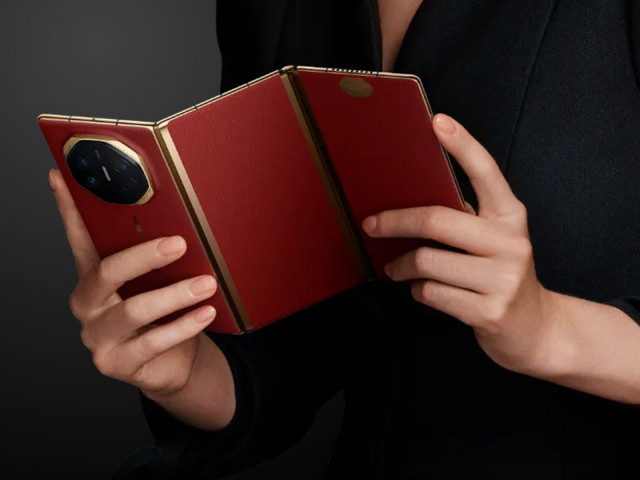

Говорител на TikTok увери, че фирмата знае колко е трудно да се модерира съдържание, така че се стреми да създава благоприятна работна среда за модераторите, включително клинична психична помощ и програми. Освен това, модераторите на TikTok вече са „втора инстанция” в редактирането, защото клиповете първо минават през инструменти с ИИ, които изглежда успешно премахват голям обем вредно съдържание.

От Open AI казват, че са благодарни за отговорната работа на модераторите, които обучават инструментите с ИИ да разпознава снимки и видеоклипове с насилие. Освен това заедно със своите партньори Open AI налага политики за защита на психичното здраве на тези екипи.

Meta, която притежава Instagram и Facebook, изисква от всички компании, с които работи, да предоставят поддръжка с обучени професионалисти 24/7. Освен това платформите съветват модераторите да персонализират наличните инструменти за замъгляване на графично съдържание – макар че така рискуват да пропуснат нещо опасно за много повече хора.

Още по темата във

facebookСподели тази статия в:

Китай пуска дроновете в бизнеса с таксита

Еврото ускори спада си спрямо долара след публикувани данни за инфлацията в Германия

26,7 милиарда години: каква е възрастта на Вселената

Митата на Тръмп възродиха силен икономически съюз

Илон Мъск пак пазарува привърженици на Тръмп

Френският съд елиминира Марин льо Пен от следващата президентска надпревара

Шведски журналист арестуван в Турция

Цената на златото продължава да расте